Sans fonction d’activation, pas d’intelligence artificielle

Actuellement le machine learning, les réseaux de neurones sont souvent comparés au cerveau humain. Mais sans un mécanisme capable de filtrer, transformer et structurer l’information, ces modèles seraient aussi efficaces qu’une lampe sans électricité. C’est là qu’interviennent les fonctions d’activation – ces gardiennes invisibles qui décident quelles informations méritent d’être transmises et lesquelles doivent être atténuées.

Si l’intelligence artificielle est un moteur, les fonctions d’activation en sont le carburant. Elles transforment des données brutes en prédictions intelligentes, sculptant la manière dont les réseaux de neurones apprennent et réagissent aux signaux qu’ils reçoivent.

Comprendre leur rôle : le filtre essentiel de l’IA

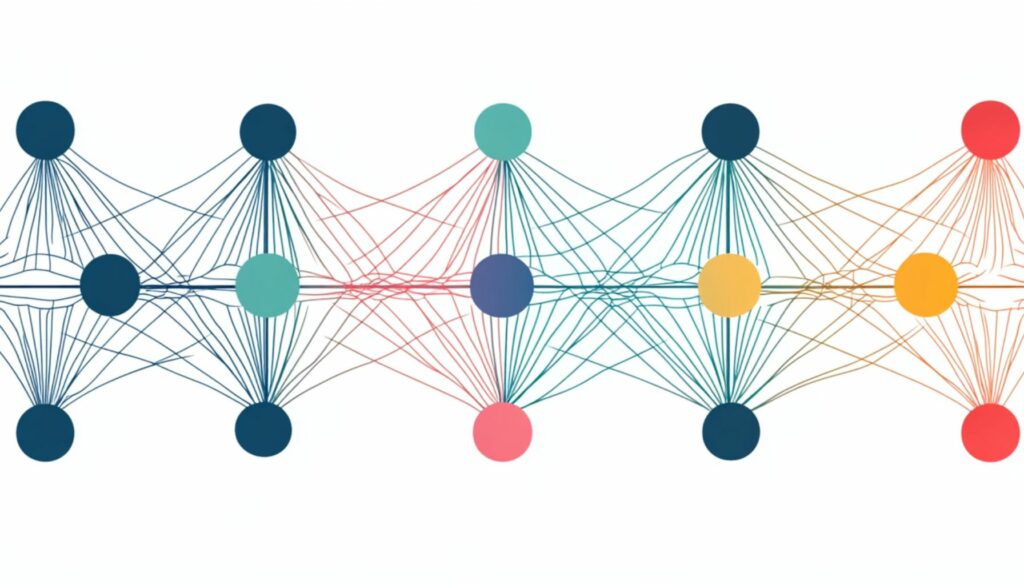

À la base, un réseau de neurones est une série de calculs mathématiques effectués couche après couche. Chaque neurone reçoit une somme pondérée de signaux en entrée, mais sans une transformation non linéaire, ces réseaux ne seraient que de simples modèles linéaires incapables de capturer la complexité des données.

Les fonctions d’activation permettent cette non-linéarité. Elles agissent comme des filtres, sélectionnant les signaux pertinents et supprimant le bruit inutile. En d’autres termes, elles déterminent si un neurone doit être activé ou non, influençant directement la capacité du modèle à apprendre des tendances complexes.

Les fonctions d’activation les plus utilisées : entre efficacité et pertinence

1. ReLU (Rectified Linear Unit) : la star des deep learning

📌 Pourquoi elle domine ? Simple, rapide, efficace.

La fonction ReLU (Rectified Linear Unit) est devenue le standard dans le deep learning. Elle agit comme un interrupteur : toute valeur négative devient zéro, tandis que les valeurs positives passent sans modification.

✅ Avantages :

- Évite le problème du gradient qui disparaît

- Accélère l’apprentissage des réseaux de neurones profonds

- Facile à calculer

⚠️ Inconvénients :

- « Dying ReLU Problem » : certains neurones peuvent devenir inactifs si les poids sont mal ajustés

Formule :

f(x)=max(0,x)f(x) = \max(0, x)f(x)=max(0,x)

2. Sigmoïde : le pionnier qui a perdu en puissance

📌 Pourquoi elle n’est plus la favorite ? Ralentie par ses propres limites.

Autrefois utilisée massivement, la fonction sigmoïde transforme l’entrée en une valeur comprise entre 0 et 1, idéal pour les modèles de classification binaire.

✅ Avantages :

- Bonne interprétabilité des résultats

- Idéale pour exprimer des probabilités

⚠️ Inconvénients :

- Provoque un gradient qui disparaît, freinant l’apprentissage

- Sensible aux valeurs extrêmes, ce qui ralentit l’entraînement

Formule :

f(x)=11+e−xf(x) = \frac{1}{1 + e^{-x}}f(x)=1+e−x1

3. Tanh : une alternative améliorée à la sigmoïde

📌 Pourquoi elle reste utilisée ? Une sigmoïde, mais plus équilibrée.

La fonction Tanh ressemble à la sigmoïde, mais elle transforme l’entrée en une valeur entre -1 et 1, ce qui améliore la stabilité des gradients.

✅ Avantages :

- Centrée autour de zéro, réduisant le biais

- Meilleure que la sigmoïde dans la plupart des cas

⚠️ Inconvénients :

- Souffre également du problème du gradient qui disparaît

Formule :

f(x)=ex−e−xex+e−xf(x) = \frac{e^x – e^{-x}}{e^x + e^{-x}}f(x)=ex+e−xex−e−x

4. Softmax : la clé des classifications multi-classes

📌 Pourquoi elle est incontournable ? Parce que choisir, c’est renoncer.

La fonction softmax est la championne du classement multi-catégories. Elle transforme les sorties d’un réseau en probabilités, garantissant que la somme totale des valeurs est égale à 1.

✅ Avantages :

- Excellente pour les classifications multi-classes

- Assure une répartition cohérente des probabilités

⚠️ Inconvénients :

- Sensible aux valeurs extrêmes

Formule :

f(xi)=exi∑jexjf(x_i) = \frac{e^{x_i}}{\sum_{j} e^{x_j}}f(xi)=∑jexjexi

Choisir la bonne fonction d’activation : un enjeu stratégique

Pas de solution universelle, chaque fonction d’activation a son territoire de prédilection.

- Classification binaire ? Sigmoïde

- Classification multi-classe ? Softmax

- Réseaux de neurones profonds ? ReLU ou variantes comme Leaky ReLU

- Données centrées autour de zéro ? Tanh

Les chercheurs et ingénieurs en IA ajustent ces choix en fonction des besoins spécifiques du modèle, cherchant le parfait équilibre entre performance, stabilité et vitesse d’apprentissage.

L’avenir des fonctions d’activation : vers plus d’adaptabilité

Avec l’essor des architectures complexes, de nouvelles approches émergent :

🔹 Swish : Développée par Google, elle offre des performances supérieures à ReLU dans certaines tâches.

🔹 Mish : Une alternative plus fluide qui améliore la propagation du gradient.

🔹 Adaptive Activation Functions : Capables d’ajuster dynamiquement leur comportement en fonction des données.

L’objectif ? Des fonctions plus flexibles, capables de s’adapter automatiquement à la structure du réseau et aux données traitées.

Les fonctions d’activation sont bien plus que de simples outils mathématiques : elles façonnent l’intelligence des réseaux de neurones, permettant aux modèles d’apprendre, de s’adapter et de prendre des décisions.

Elles sont au cœur de l’innovation en deep learning, et leur évolution sera déterminante pour les prochaines avancées de l’intelligence artificielle.